El concepto de entropía desarrollado en respuesta a la observación de que una cierta cantidad de energía liberada de funcionales reacciones de combustión siempre se pierde debido a la disipación o la fricción y por lo tanto no se transforma en trabajo útil. Los primeros motores de calor como Thomas Savery (1698), el Newcomen motor (1712) y el Cugnot de vapor de tres ruedas (1769) eran ineficientes, la conversión de menos de dos por ciento de la energía de entrada en producción de trabajo útil; una gran cantidad de energía útil se disipa o se pierde en lo que parecía un estado de aleatoriedad inconmensurable. Durante los próximos dos siglos los físicos investigaron este enigma de la energía perdida, el resultado fue el concepto de entropía.

En termodinámica, la entropía (simbolizada como S ) es una magnitud física que, mediante cálculo, permite determinar la parte de la energía que no puede utilizarse para producir trabajo. Es una función de estado de carácter extensivo y su valor, en un sistema aislado, crece en el transcurso de un proceso que se dé de forma natural. La entropía describe lo irreversible de los sistemas termodinámicos. La palabra entropía procede del griego (ἐντροπία) y significa evolución o transformación. Fue Rudolf Clausius quien le dio nombre y la desarrolló durante la década de 1850; y Ludwig Boltzmann, quien encontró en 1877 la manera de expresar matemáticamente este concepto, desde el punto de vista de la probabilidad.

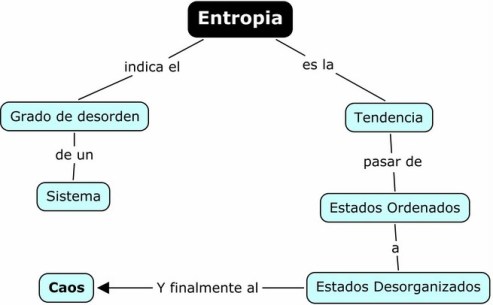

La función termodinámica entropía es central para la segunda Ley de la Termodinámica. La entropía puede interpretarse como una medida de la distribución aleatoria de un sistema. Se dice que un sistema altamente distribuido al azar tiene alta entropía. Un sistema en una condición improbable tendrá una tendencia natural a reorganizarse a una condición más probable (similar a una distribución al azar), reorganización que dará como resultado un aumento de la entropía. La entropía alcanzará un máximo cuando el sistema se acerque al equilibrio, y entonces se alcanzará la configuración de mayor probabilidad.

Una magnitud es una función de estado si, y sólo si, su cambio de valor entre dos estados es independiente del proceso seguido para llegar de un estado a otro. Esa caracterización de función de estado es fundamental a la hora de definir la variación de entropía.

Ecuaciones

Esta idea de desorden termodinámico fue plasmada mediante una función ideada por Rudolf Clausius a partir de un proceso cíclico reversible. En todo proceso reversible la integral curvilínea de  sólo depende de los estados inicial y final, con independencia del camino seguido (δQ es la cantidad de calor absorbida en el proceso en cuestión y Tes la temperatura absoluta). Por tanto, ha de existir una función del estado del sistema, S=f(P,V,T), denominada entropía, cuya variación en un proceso reversible entre los estados 1 y 2 es:

sólo depende de los estados inicial y final, con independencia del camino seguido (δQ es la cantidad de calor absorbida en el proceso en cuestión y Tes la temperatura absoluta). Por tanto, ha de existir una función del estado del sistema, S=f(P,V,T), denominada entropía, cuya variación en un proceso reversible entre los estados 1 y 2 es:

.

.

Téngase en cuenta que, como el calor no es una función de estado, se usa δQ, en lugar de dQ.

La entropía física, en su forma clásica, está definida por la ecuación siguiente:

o, más simplemente, cuando no se produce variación de temperatura (proceso isotérmico):

donde S es la entropía,  la cantidad de calor intercambiado entre el sistema y el entorno y T la temperatura absoluta en kelvin.

la cantidad de calor intercambiado entre el sistema y el entorno y T la temperatura absoluta en kelvin.

Unidades: S=[cal/K]

Los números 1 y 2 se refieren a los estados iniciales y finales de un sistema termodinámico.

El significado de esta ecuación es el siguiente:

Cuando un sistema termodinámico pasa, en un proceso reversible e isotérmico, del estado 1 al estado 2, el cambio en su entropía es igual a la cantidad de calor intercambiado entre el sistema y el medio dividido por su temperatura absoluta.

Cero absoluto

Solo se pueden calcular variaciones de entropía. Para calcular la entropía de un sistema, es necesario fijar la entropía del mismo en un estado determinado. La tercera ley de la termodinámica fija un estado estándar: para sistemas químicamente puros, sin defectos estructurales en la red cristalina, de densidad finita, la entropía es nula en el cero absoluto (0 K) o (-273.16°C)

Esta magnitud permite definir la segunda ley de la termodinámica, de la cual se deduce que un proceso tiende a darse de forma espontánea en un cierto sentido solamente. Por ejemplo: un vaso de agua no empieza a hervir por un extremo y a congelarse por el otro de forma espontánea, aún cuando siga cumpliéndose la condición de conservación de la energía del sistema (la primera ley de la termodinámica).

Entropía y reversibilidad

La entropía global del sistema es la entropía del sistema considerado más la entropía de los alrededores. También se puede decir que la variación de entropía del universo, para un proceso dado, es igual a su variación en el sistema más la de los alrededores:

Si se trata de un proceso reversible, ΔS (universo) es cero, pues el calor que el sistema absorbe o desprende es igual al trabajo realizado. Pero esto es una situación ideal, ya que para que esto ocurra los procesos han de ser extraordinariamente lentos, y esta circunstancia no se da en la naturaleza. Por ejemplo, en la expansión isotérmica (proceso isotérmico) de un gas, considerando el proceso como reversible, todo el calor absorbido del medio se transforma en trabajo y Q= -W. Pero en la práctica real el trabajo es menor, ya que hay pérdidas por rozamientos, por lo tanto, los procesos son irreversibles.